Александр занимается разработкой учебных программ, чтением лекций, проведением семинаров, практических и лабораторных работ. Под его руководством уже не один десяток специалистов успешно защитили выпускные квалификационные работы бакалавра и магистерские диссертации.

Среди его кейсов работа в ЗАО «ТИТАН МЕТА», Московском государственном университете приборостроения и информатики, Национальном исследовательском университете «Высшая школа экономики» и Luxoft Training.

Александр – кандидат технических наук, доцент. С 1991 г. занимается разработкой информационных и коммуникационных систем, за это время прошел путь от программиста до начальника отдела информационных систем.

С 1994 г. преподает дисциплины, связанные с управлением данными, проектированием информационных систем и разработкой программного обеспечения.

С 2014 г. Александр являлся штатным экспертом Luxoft Training по направлению «Разработка и архитектура ПО, СУБД Oracle», где занимается проведением тренингов, разработкой тренинговых программ и развитием данного направления.

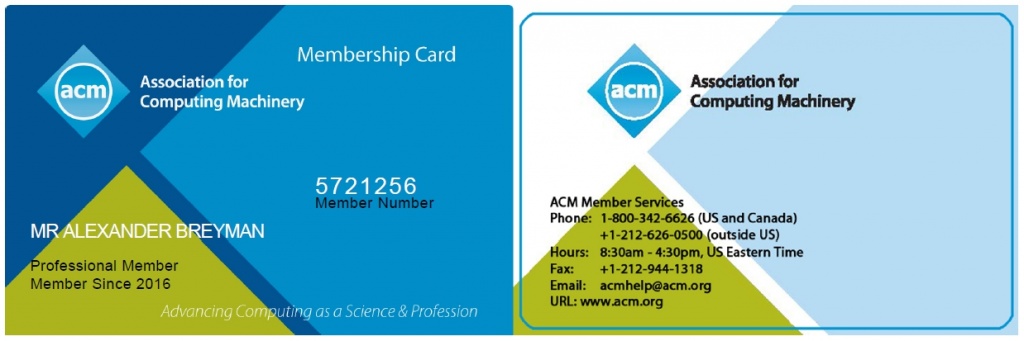

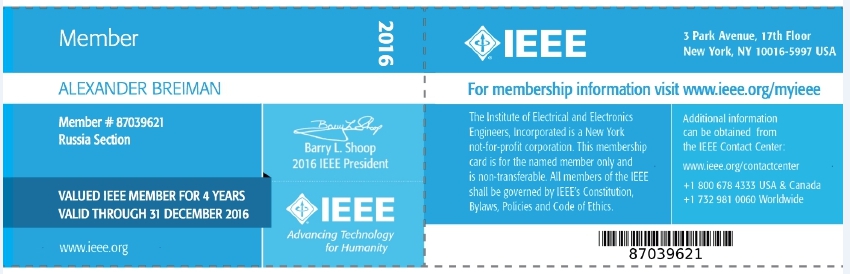

Курсы, сертификаты, членство в профессиональных организациях:

2009 г. — повышение квалификации в Московском государственном университете приборостроения и информатики по программе «Информационная компетентность в профессиональной деятельности преподавателя вуза».

2011 г. — повышение квалификации в Информационно-Вычислительном Центре Московского энергетического института (технического университета) по программе «Современные технологии построения баз данных на примере Microsoft SQL Server 2008. Web-приложения и современные средства разработки. Современные технологии построения компьютерных сетей с использованием Microsoft Windows Server 2008 R2».

2024 г. — Сертифицированный тренер PostgreSQL по курсу DBA1 «Администрирование PostgreSQL 13. Базовый уровень».

46 200 ₽

41 580 ₽ — для физ. лиц

BigData SQL: Hive

В курсе изучаются основы архитектуры Hive , разработка скриптов по загрузке, трансформации и выгрузке данных. Рассматриваются все необходимые технические подробности. Конфигурирование и настройки производительности.

16 400 ₽

Основы Apache Spark

Обучайтесь основам Apache Spark и используйте его для эффективной обработки больших данных. В данном курсе вы узнаете все необходимое для работы с фреймворком Apache Spark, включая программирование на Python, создание табличных запросов с помощью Spark SQL и обработку данных с использованием RDD и DataFrame. Уникальное сочетание теории и практики поможет вам быстро освоить все нюансы Spark и применить их на реальных проектах.

49 700 ₽

Фреймворк Apache Spark для разработчиков: продвинутый уровень

Глубокое погружение в внутреннее устройство Apache Spark и его компонентов. Этот курс поможет вам понять, как устроены и работают различные модули Spark, такие как Spark Core, Spark SQL, и Spark Streaming. Вы научитесь оптимизировать производительность и эффективно использовать ресурсы кластера.

54 500 ₽